GPT-4o語音功能終於如期而至,科幻版Her走進現實!一些灰階測試到的網友已經玩瘋了,不過,OpenAI目前只給了4種預設語音。另外,GPT-4o新模型的輸出token也暴漲16倍至64K。

奧特曼的承諾,終於兌現了。

趕在7月結束前,GPT-4o語音模式終於開啟了灰階測試,一小部分ChatGPT Plus用戶已經拿到了嚐鮮入場券。

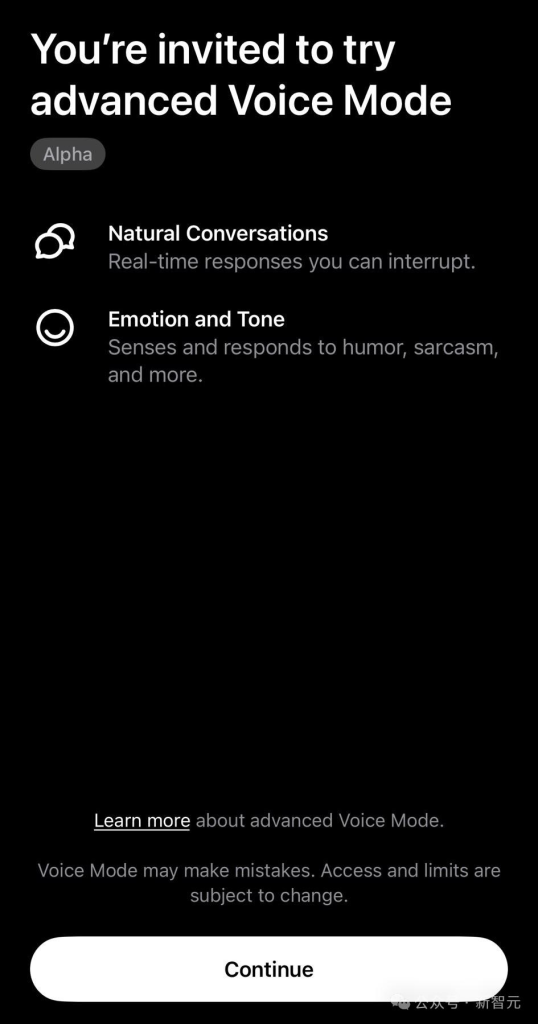

如果打開ChatGPT App之後看到了下面這個介面,恭喜你成為了第一批幸運兒。

OpenAI稱,進階語音模式提供了更自然、即時對話,可以隨意打斷,甚至它還可以感知、回應你的情緒。

預計今年秋季,所有ChatGPT Plus用戶,都能運用此功能。

另外,視訊和螢幕分享更強大的也在稍後推出。也就是,開啟鏡頭,就能和ChatGPT「面對面」聊天了。

一些被灰階到的網友紛紛開啟測試,發現了GPT-4o語音模式的許多用例。

不,有人就讓它充當「二外教練」,教自己練習口語。

ChatGPT在下面的教學中,幫助網友修正了Croissant(羊角麵包)、Baguette(法國長棍)的發音。

同時,GPT-4o的輸出token飆升了16倍,從最初4000個token增加到64000個token。

這是OpenAI最近在官方網頁中,悄悄推出的測試版新模型gpt-4o-64k-output-alpha。

更長的輸出token,就意味著,一次性可以得到大約4個完整的長篇電影劇本。

01 Her已來

之所以現在才放出GPT-4o語音功能,是因為過去幾個月裡,OpenAI一直在進行安全性、品質測試。

他們與100+紅隊人員,就45種語言對GPT-4o語音能力進行了測試。

為保護人們的隱私,團隊訓練模型只使用4種「預設聲音」說話。

他們還創建了一個系統,去阻止在這4種聲音之外,其他聲音的輸出。

此外,內容過濾也是不可或缺,團隊也採取措施阻止暴力、有關版權內容的產生。

OpenAI預告,計劃在8月初,會發布一份關於GPT-4o能力、限制、安全評估的詳細報告。

全網實測

以下是一些網友分享的GPT-4o語音模式的案例。

ChatGPT可以表演節奏口技。

ChatGPT還可以以害羞、生氣、更憤怒的語氣講出了關於啤酒的笑話。

還有網友專為ChatGPT講了一個笑話「為什麼科學家不相信Adam-Atom,因為它們構成了一切」。

ChatGPT不失尷尬地笑了起來。

更搞笑的是,ChatGPT學起貓叫還是有一套的。

有人經過一番測試下來,發現ChatGPT高級語音模式非常快,答案幾乎沒有延遲。

當被要求模仿一些聲音時,它總是可以真實地復刻出聲音。而且不同口音,也可以模仿出來。

下面這個影片中,展示了AI充當足球比賽解說員的場景。

ChatGPT用中文講故事,也很生動。

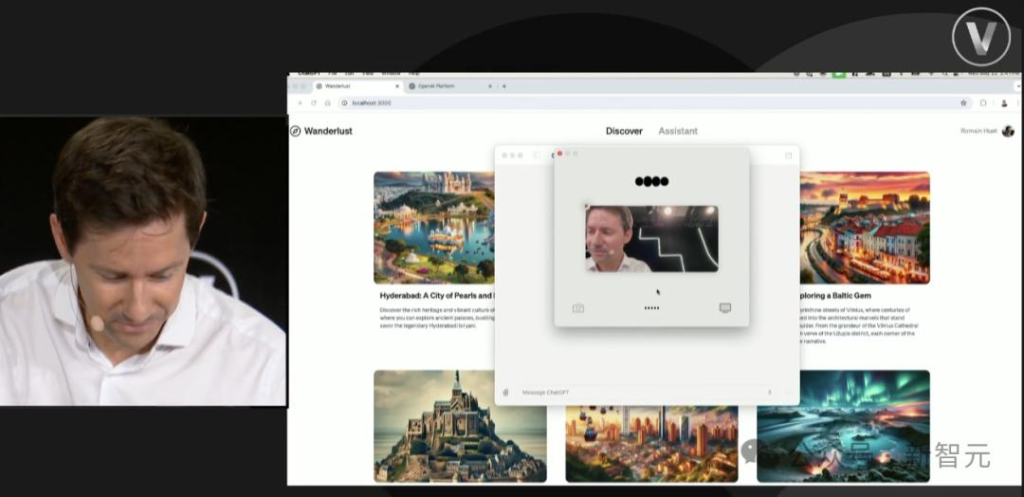

OpenAI雖然聲稱,影片和螢幕分享功能稍後推出,不過已經有網友先用上了。

網友有一隻貓咪新寵,為它搭建了小窩,準備了吃食,但不知道怎麼樣,於是就問問ChatGPT。

在影片的對話中,網友向它展示了貓咪的房子,ChatGPT看完後評論道,「一定非常舒適」,並關心貓咪如何。

網友表示,目前它還沒有吃東西,看起來有點擔心。 ChatGPT安慰道,「這很正常,對於貓咪來說需要適應的時間」。

可以看出,整個問答過程非常流暢,給人一種與真人交流的感受。

網友還翻出了日文版介面遊戲機,但自己又不會日文。

這時,他一邊向ChatGPT展示遊戲介面,一邊讓其幫自己做翻譯,最後胡一起通關遊戲。

不得不說,有了視覺+語音模式的加持,ChatGPT強了很多。

02 GPT-4o Long Output悄悄上線,輸出高達64K

另外,支援更大token輸出的GPT-4o隨之而來。

就在昨天,OpenAI正式宣布向提供測試者GPT-4o Alpha版本,每次請求支援最多輸出64K token,相當於200頁小說。

測試者可以從“gpt-4o-64k-output-alpha”,存取GPT-4o的長輸出功能。

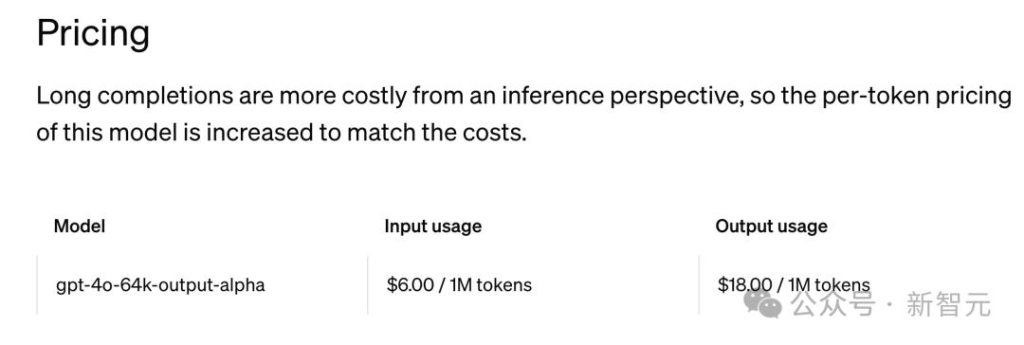

不過,新模型的價格再次刷新天花板。每百萬輸入token 6美元,每百萬輸出token 18美元。

雖說輸出token是GPT-4o的16倍,但價格也漲了3美元。

這麼一比,果然還是gpt-4o-mini價格香!

研究員Simon Willison表示,長輸出主要用於資料轉換用例。

例如,將文件從一種語言翻譯成另一種語言,或從文件中提取結構化數據,幾乎每個輸入token都需要在輸出的JSON中使用。

在此之前,他所知道的最長輸出模型是GPT-4o mini,為16K token。

為什麼推出更長輸出的模型?

顯然,更長的輸出,可以讓GPT-4o提供更全面、細緻的反應,對於一些場景非常有幫助。

比如,編寫程式碼、以及對寫作的改進。

這也是基於使用者的回饋——需要更長輸出內容才能滿足用例,OpenAI才做出的調整。

上下文和輸出之間的區別

GPT-4o自推出以來,便提供了最大128K的上下文視窗。而對於GPT-4o Long Output,最大上下文視窗仍然是128K。

那麼,OpenAI如何在維持整體上下文視窗為128K的情況下,將輸出token數量從4,000增加到64,000呢?

這是因為,OpenAI在最初就限制了輸出token數量,最大為4000個token。

這意味著,使用者可以在一次互動中最多以124,000個token作為輸入,也最多只能得到4,000個輸出token。

當然,你也可以輸入更多token,那就代表輸出token更少了。

畢竟長下文長度(128K)就固定在那裡,不管輸入怎麼變,輸出token也不會過4000。

而現在,OpenAI將輸出token長度限制在64,000 token,也就是說,你可以比以往多輸出16倍的token。

畢竟,輸出計算量更大,價格漲幅也更大。

同樣,對於最新的GPT-4o mini,上下文也是128K,但最大輸出已提升至16,000個token。

那麼,使用者可以提供最多112,000個token作為輸入,最終得到最多16,000個token的輸出。

總的來說,OpenAI在這裡提供了一個方案,限制輸入token,以獲取LLM更長的回應,而不是直接擴大上下文長度。

而市面上其他模型,長的都已經超過百萬了(Gemini),稍微短一些的也有200K(Claude);甚至有的模型輸出都已經達到了200K,而OpenAI還在這兒摳摳搜搜。

這也就把難題丟給了開發者:想要輸入多,那就得接受輸出少;想要輸出多,那就得輸入少一些。

具體怎麼衡量,看你們自己願意犧牲哪一個了……

寫在文章最後,如果您需要付費ChatGPT服務,可以開通一張國際虛擬信用卡。牛牛平台就是專門提供國際虛擬信用卡的平台,敢興趣的朋友可以回到官網或增加客服TG(@bullbull999)進行了解。